站長之家(Chinaz.com)注:網站鏈接分析,源於對Web結構中超鏈接的多維分析,是網站優化運營中不可缺少問題診斷方法。百度站長平台也推出其官方的鏈接分析工具。那麼,我們該如何利用好百度站長工具的鏈接分析功能,來定位網站可能存在的SEO問題呢?

以下為來自百度站長社區斑竹響1亮2的3名4字的分享:

有一次在社區裡面看到有站長朋友提問,說百度站長工具的鏈接分析裡,怎麼出現了錨文本是@NULL@的數據,感到非常不明覺厲。

然後我就試著聯系了一些平時經常打交道的站長朋友,問了下他們是否關注過百度站長工具中的鏈接分析,是否定期進行過統一分析,當出現大量死鏈數據時,是否對問題進行了定位……結果發現有很多站長朋友,在平時很少進行這樣的分析工作,所以當出現問題的時候,就感到不明覺厲,不由得大罵度娘坑爹。

實際上,度娘到底坑不坑爹我是不知道啦,不過我想說度娘只是把問題反映出來,更多地還需要我們自己去定位問題並進行處理,才能確保網站不會因為該問題而受到較大程度的影響。

於是,我就有了制作本期專題的打算,專題地址:http://bbs.zhanzhang.baidu.com/thread-75492-1-1.html。

1、本文的主要內容有哪些呢?

(1)查找是否有黑鏈出現——從日志分析,百度蜘蛛抓取了網站的哪些預期外的頁面,是否存在黑鏈。(這個可能要先賣個關子,因為這又是個大工程啦,本期專題會提到一些)

(2)百度站長工具外鏈分析——查看是否有垃圾外鏈、黑鏈等,以及鏈向的站內什麼地方,如何處理。(本期裡面也有所涉及)

(3)百度站長工具鏈接分析——三大死鏈(內鏈死鏈、鏈出死鏈、鏈入死鏈),批量下載數據,合並數據,excel操作,按邏輯分類,定位問題,處理問題。(定位和處理,材料不夠,因為好多已經處理過了,沒有材料了= =|||||)

(4)從分析這些數據,得到的與SEO效果相關的其他信息(垃圾搜索引擎、垃圾外鏈帶來的無用抓取,浪費資源配額,如何拒絕。)

(5)如何自動化地使用shell腳本,定位到被百度蜘蛛抓取到的死鏈,並進行復查,然後將確定為死鏈的URL進行自動化提交。(本期專題內容太多,留作下期專題用)

(6)分析工具介紹(firefox設置,插件,excel,windows命令提示符批處理)

2、本文中主要使用到的工具

(只是結合例子中,如果有其他相似功能的工具,請結合自身習慣使用即可)

【浏覽器】火狐(Firefox)浏覽器,版本無所謂

【插件】:Launch Clipboard

功能:一鍵打開剪切板中存在的URL。(注意URL中只能有英文數字標點,如果有中文可能無法被識別)。快捷鍵:alt + shift +K(先復制好單個或者多個URL)

設置:打開選項設置,選擇好下載文件自動保存的位置(我這裡選擇了桌面,你也可以單獨創建一個文件夾,好對批量下載的文件進行歸類)

【表格處理】:Microsoft Office 2013 Excel

【文本處理】:Notepad++

【批量處理】:Windows自帶命令提示符

一、我們可以先看一下外鏈分析。

分析外鏈數據的主要目的是,找出垃圾外鏈,主動去封堵垃圾外鏈可能對網站造成的惡劣影響。最終目標:

1、找到垃圾外鏈的域名,進行防盜鏈處理(針對來源為垃圾域名的,直接返回404狀態碼);

2、處理站內可能存在問題的頁面。

這裡,我會重點講解第一點;第二點比較簡單,我會講解得比較粗略。

1、定位出垃圾域名。

圖注:可以看到這是一個明顯不正常的趨勢圖

我們可以下載外鏈數據,來進行初步分析。

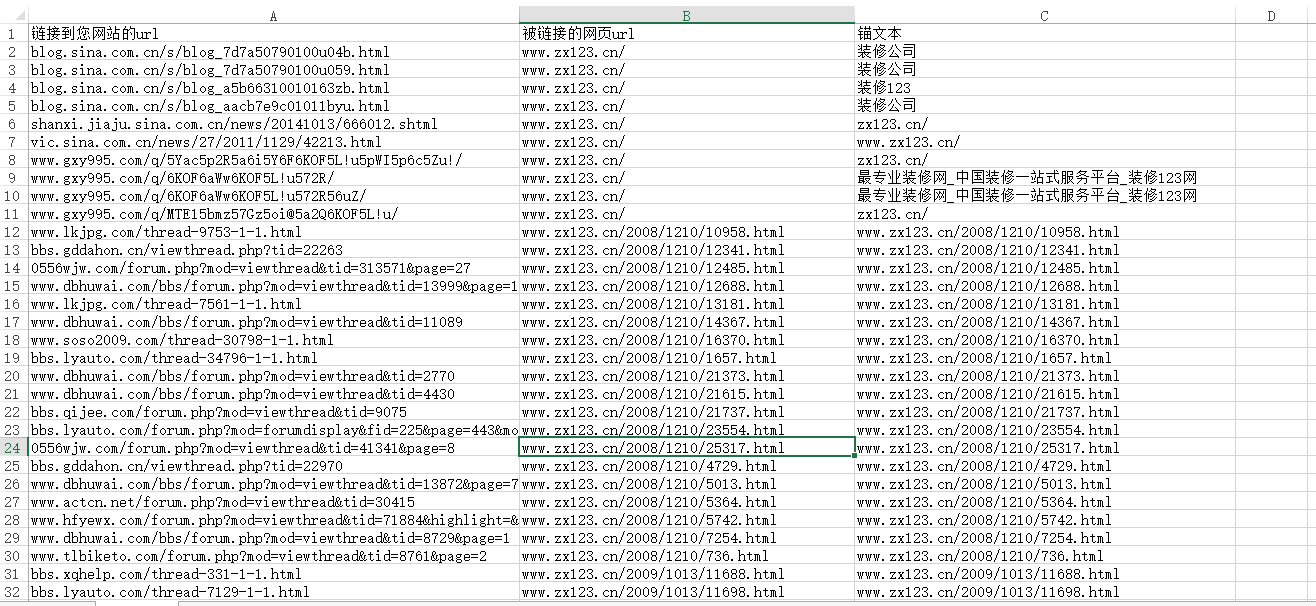

圖注:下載得到的表格文件(csv逗號分隔符)

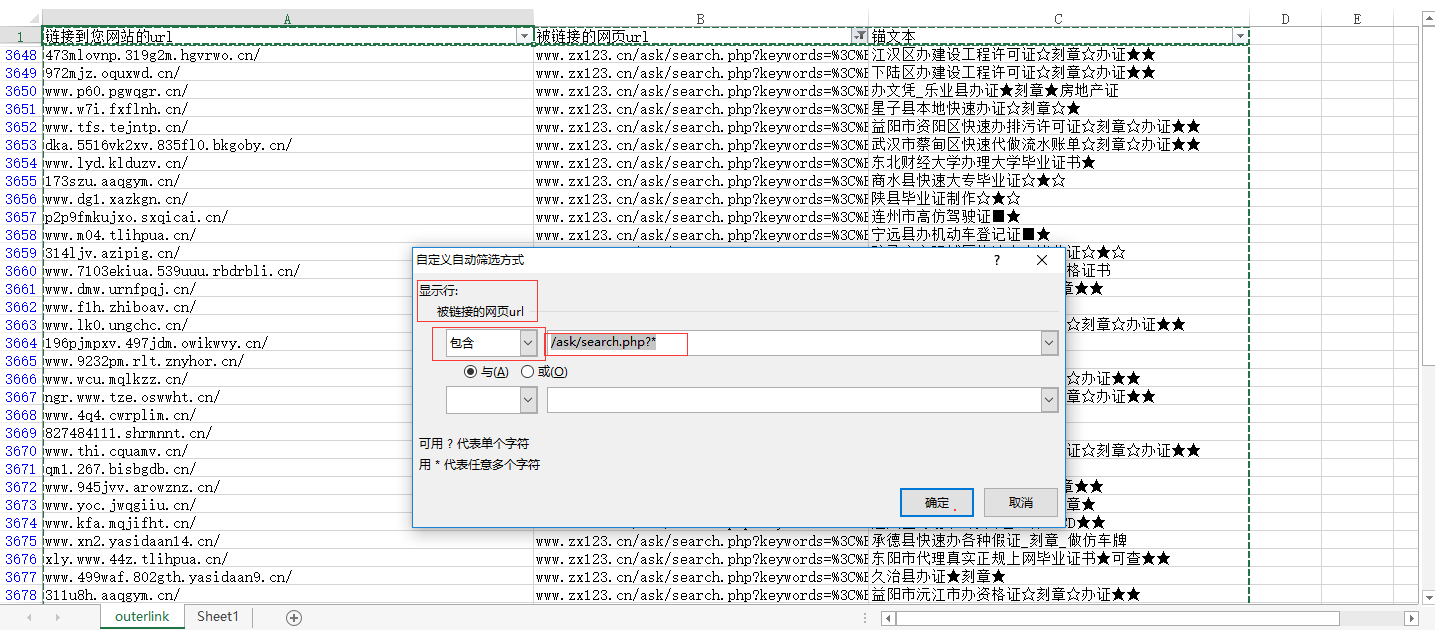

但是這樣一份原始數據,是很難進行分析的。因此我們需要按照一定邏輯對其進行分析——就是按照【被鏈接的網頁url】進行分類。

首先,我們可以快速浏覽一下,進行直觀判斷,這些頁面大部分是什麼頁面呢?

針對我們網站的情況來說,外鏈數據分為兩類,正常外鏈與垃圾外鏈。

而垃圾外鏈又分為兩種:站內搜索結果頁面(垃圾搜索詞)以及被黑客入侵植入的黑鏈(已經處理為死鏈)。

我們進行數據處理的目的有兩個:識別出哪些是正常外鏈,哪些是垃圾外鏈,並根據垃圾外鏈的相關數據,進行一些處理,保護好網站;並且需要使被垃圾鏈接指向的頁面,不被搜索引擎抓取(浪費抓取資源配額)以及被收錄/索引(保證網站詞庫不受污染,不為網站帶來形象與關鍵詞方面的負面影響)。

第一步,篩選出網站的搜索結果頁面