robots.txt 原來還可以這樣寫

編輯:SEO優化集錦

關於robots的寫法網上有很多的介紹,Robots可以用來防止搜索引擎抓取那些我們不想被搜索引擎索引的內容,很多網站都在裡面加入網站的地圖sitemap.xml,這樣可以讓蜘蛛快速的爬行網站。

格式:

User-agent: *

Disallow:

Sitemap:sitemap.xml

我們來看看一些大型網站的robots.txt是怎麼樣寫的!

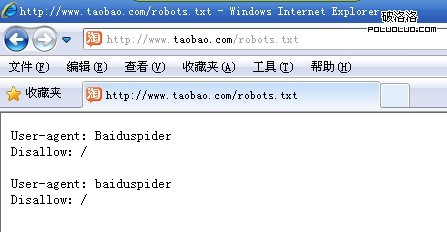

淘寶的robots.txt,屏蔽了百度蜘蛛

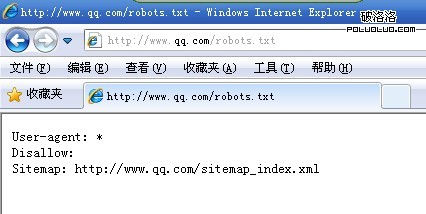

QQ在robots中加入了sitemap

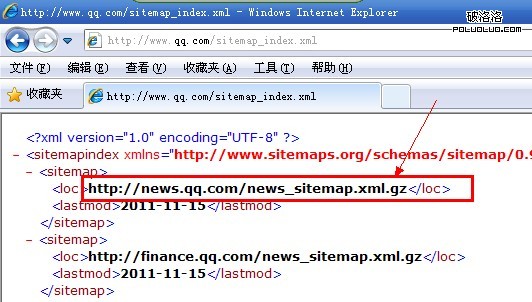

打開qq的sitemap之後發現,存在這樣的壓縮包,下載回來打開裡面放的是sitemap,難道蜘蛛可以分析壓縮包了?像我還是頭一次見到這樣的寫法。

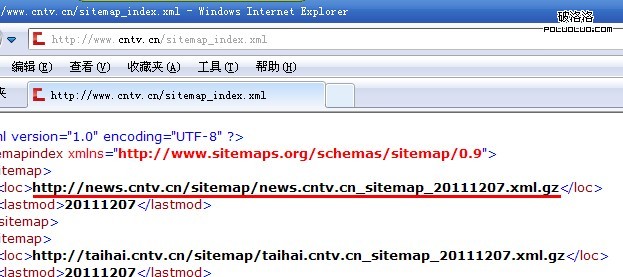

CCTV也同樣是這樣的寫法

在robots.txt中加入sitemap這樣做到底能不能增加收錄,站長朋友們不妨試試!最後感謝瓜視雲點播www.tvgua.com站長提供配圖!

小編推薦

熱門推薦