許多站長都有查看網站日志的習慣,這麼做的主要目的就是為了分析蜘蛛爬行網站的情況,當然其中多數站長也只是簡單的了解一下當天蜘蛛爬行的次數,這一 點就足夠發現問題了。有時候,我們會覺得自己的網站已經相當完美了,而正常優化過程中,蜘蛛卻對此不感冒,讓人很是著急。

了解原理就很容易理解,搜索引擎借助蜘蛛在互聯網這張大網中搜尋“獵物”,它唯一所能依據的線索就是鏈接了,找到新的鏈接後,根據復雜的算法最終對網 站進行排名,儲存在數據庫中。很多網站可能會因為網站結構混亂失去蜘蛛到訪的機會,然而蜘蛛不訪問網站的因素有很多,下面我們一起總結一下:

圖片、flash等內容過多

不得不說,搜索引擎發展到現在,已經比較的智能化了,去年google就推出了圖片搜索功能,能夠分析圖片的色彩、像素比例而找到圖片的出處。然而這 項技術對於搜索引擎完全的識別圖片中的信息還有不小的差距,而很多站長或是不懂得搜索引擎優化,或是考慮網站美觀和內容豐富,往往會在頁面中嵌入大量高清 圖片、flash,即使你的網站內容再好,蜘蛛也無法知道,只能繞道而行了。現在網絡上有許多模擬蜘蛛抓取的工具,有類似情況的網站站長可以查詢一下自己 網站的信息,看看蜘蛛能夠發現的信息和人眼看到的有多大差距。

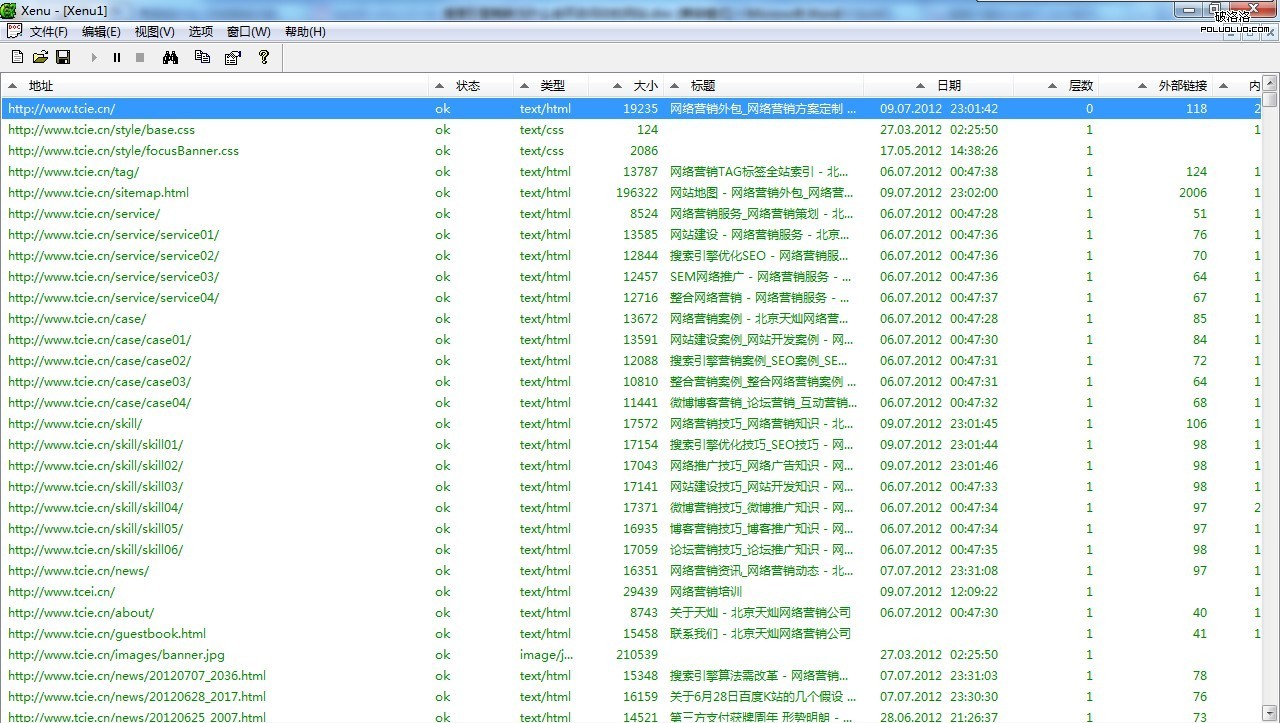

網站死鏈接過多

我們可以想象,蜘蛛興高采烈的來到你的網站,開始逐個鏈接的搜尋,以為發現了一堆好的內容,然而卻是一堆打不開的鏈接等著她,一次、兩次、三次,每次 來都是這種情況,所以她生氣了,就再也不會訪問你的頁面了。大部分的網站都存在死鏈接,只要我們能夠及時的發現並清除掉就沒有問題了,你可以利用強大的 xenu,也可以查看你的網站日志,發現返回404狀態碼的一律清除。

上圖是用xenu掃描網站時的界面。

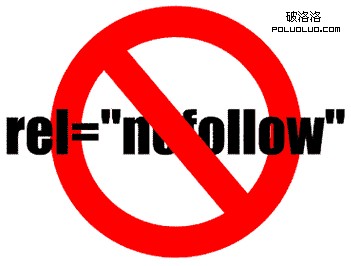

外鏈與nofollow

之所以蜘蛛能夠成功的找到並訪問你的站點,是因為其他網站上存在你網站的鏈接。想要蜘蛛更頻繁的光臨,在建立外鏈時就應該考慮外鏈網站權重,收錄數越 大、PR值越高,快照更新越快的網站權重就越高。另外有些無良站長在做友情鏈接時,會有意設置nofollow,這樣的外鏈在蜘蛛眼裡形同虛設,如果你網站的外鏈有這種現象,請及時撤除。

網站代碼復雜

網站建設中,代碼優化非常重要,冗長代碼對網站無任何意義,而且還會影響打開速度和搜索引擎蜘蛛的判斷。

網站邏輯結構復雜

正確的網站邏輯結構應該是扁平狀的樹形結構,也就是說,蜘蛛通過首頁訪問,能夠達到任何一個欄目頁,通過欄目頁又能達到任何一個內容頁,這個次數應該被限定在3次以內(較大的網站可以多幾層)。如果網站層次太多,網站權重又不夠高,蜘蛛就沒有興趣去一層層的搜尋了。

網站地圖錯誤

網站地圖是搜索引擎全面認識網站的好工具,對於蜘蛛而言,網站地圖就像花名冊,好的網站地圖能讓蜘蛛很有指向性的訪問網站中的任何頁面。所以,我們在 制作網站地圖時就需要謹慎行事了。網絡上也有很多制作網站地圖的工具,為了確保萬無一失,大家也可以作為訪客進行訪問來加以驗證。本文由網絡營銷公司 http://www.tcie.cn提供,轉載請注明出處。

- 上一頁:淺談百度最近更新波動

- 下一頁:實例分析網站流量爆發策略