robots文件支持中文目錄嗎?

編輯:關於SEO

什麼是robots文件?

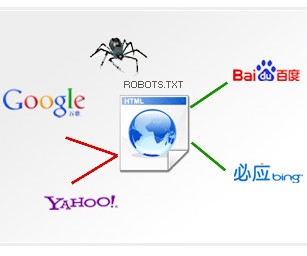

robots是站點與spider溝通的重要渠道,站點通過robots文件聲明該網站中不想被搜索引擎收錄的部分或者指定搜索引擎只收錄特定的部分。請注意,僅當您的網站包含不希望被搜索引擎收錄的內容時,才需要使用robots.txt文件。

有同學問百度站長學院一個關於robots的問題:我們有個站點的目錄結構使用的是中文,這樣式兒的:www.tianyaseo.com/教程/123.html,那在制作robots文件和sitemap文件的時候,可以直接使用中文嗎?百度能獲取到嗎?在實際操作中我們發現,sitemap中有文件是可以生效的,但robots封禁貌似沒有反應,所以想確認一下:robots文件是否支持中文?

工程師解答:Baiduspider目前(2016年10月)在robots裡是不支持中文的。

同學追問:那我們進行UrlEncode編碼會不會支持呢?比如這種:http://www.a.cn/%E7%89%B9%E6%AE%8A:%E6%B5%8F%E8%A7%88/%E7%94%9F%E6%AD%BB%E7%8B%99%E5%87%BB:%E7%99%BD%E9%93%B6%E5%8A%A0%E7%89%B9%E6%9E%97

(知識普及:UrlEncode是一個函數,可將字符串以URL編碼,用於編碼處理。)

工程師解答:robots文件支持這種寫法。但是否生效,還要取決於當時BaiduSpider抓取的是哪種形式結構的鏈接,如果是UrlEncode編碼就可以生效,如果是中文就非常不幸了。

小編推薦

熱門推薦